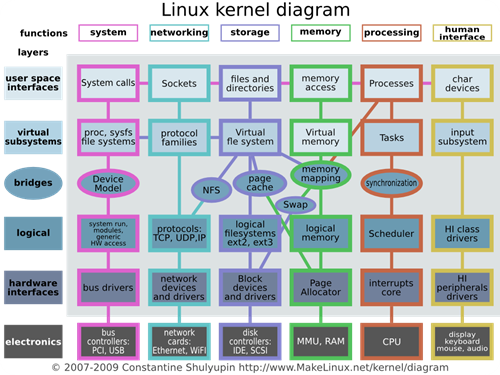

La versión 3.11 del Linux kernel ya esta oficialmente disponible en el repositorio oficial del Linux kernel. La nueva rama 3.11 aporta bastantes novedades como es habitual en un cambio de rama del kernel. En su mayoría y en términos generales la versión 3.11 se centra en la gestión y ahorro de energía. En la rama 3.10 se introdujeron muchos cambios en la arquitectura del kernel favoreciendo el soporte de nuevas tecnologías y hardware moderno. Los cambios mas notables fueron el cese de soporte para los procesadores 386 y el nuevo gestor de memoria que aprovecha mucho mejor los recursos del hardware.

La nueva version aporta ciertos elementos que también van a beneficiar mucho a las nuevas maquinas y que ademas estaban muy solicitadas por los usuarios de Linux. Empezando por el soporte mejorado para SSD (Discos de estado solido) y nuevos controladores para los adaptadores Wi-Fi con el nuevo estándar 802.11ac.

Vamos a profundizar en los cambios y novedades del Linux kernel 3.11:

Sistema de almacenamiento.

El kernel ahora integra una función de mapeado mucho mas avanzada que puede ir cacheando información en tiempo real, este nuevo modulo denominado drm-cache puede ser utilizado para crear configuración de SSD + HDD y utilizar el primero como cache del sistema. En sistemas como Windows es necesario instalar un controlador especifico del fabricante para configurar un sistema de este tipo, pero no es una solución limpia ni estable. Con este modulo el soporte esta integrado y es nativo desde el propio kernel por lo que el sistema operativo o distribución no dependerá de un modulo extra, si no que sera un estándar en todas las distribuciones que integren el kernel 3.11.

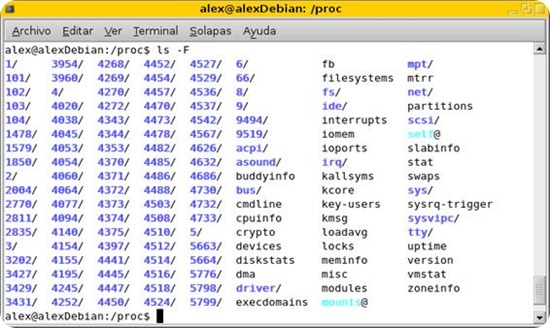

Sistema de ficheros

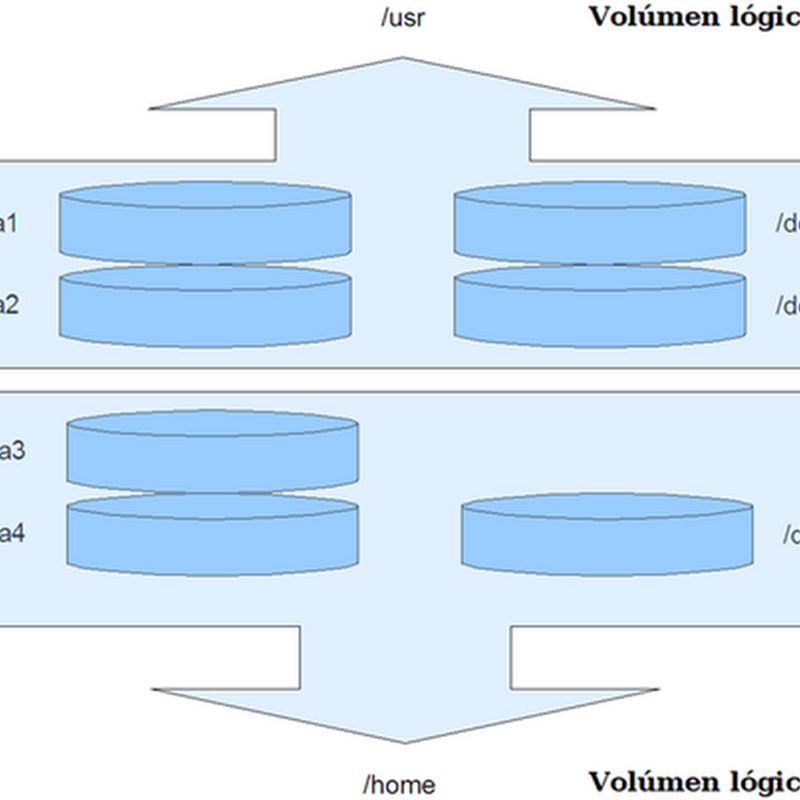

Ahora el sistema de archivos Btrfs esta incluido por defecto y todas sus características soportadas también. Cualquier distribución con el kernel 3.11 podrá hacer uso nativo de este nuevo sistema de ficheros sin necesidad de añadir ningún modulo extra por los desarrolladores de la distribución. Ademas del soporte nativo, también se añade la posibilidad de realizar una configuración RAID 0 y 1 con el sistema Btrfs, teniendo en cuenta que es un sistema de archivos fuertemente destinado a servidores, las configuraciones RAID son muy comunes, en especial RAID 1.

Se corrigen varios errores encontrados relacionados con el sistema de archivos Ext4 que afectaban al rendimiento en entornos y situaciones muy concretas. Sobretodo en configuraciones con SSD sin el comando TRIM activado.

Se mejora la sincronización entre diferentes discos duros con los formatos Ext3 y Ext4, sobretodo bajo condiciones RAID. De esta forma si se produce un apagado repentino o fallo de hardware se minimizan las posibilidades de corrupción de datos.

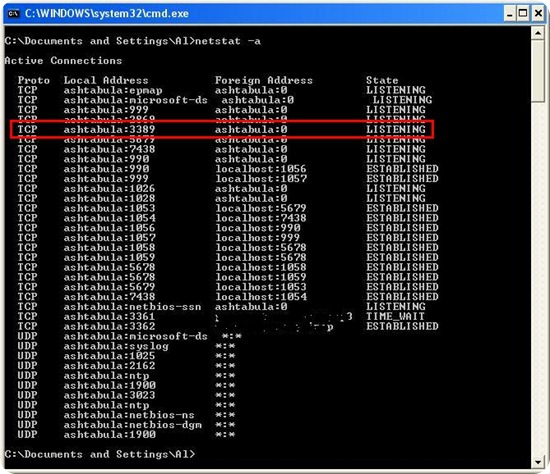

Redes.

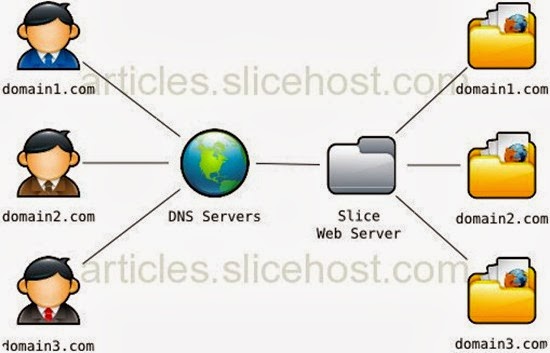

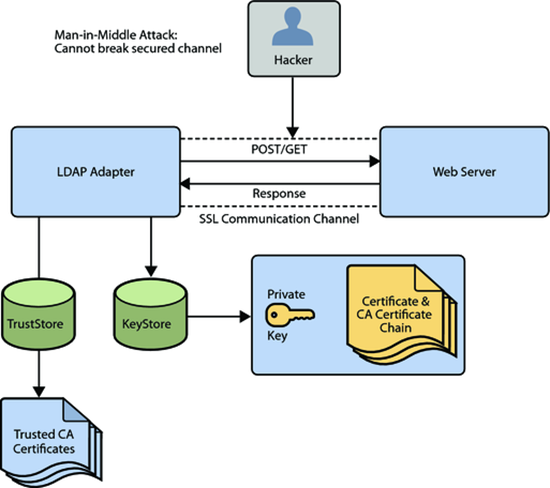

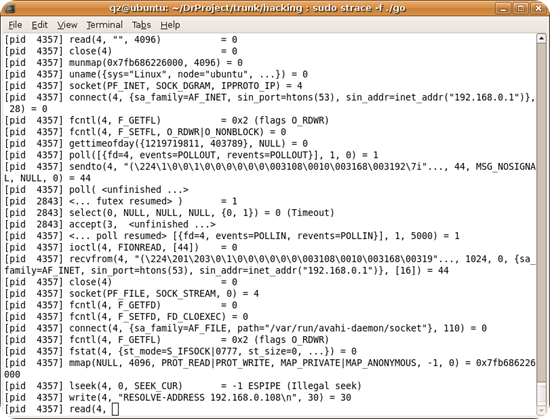

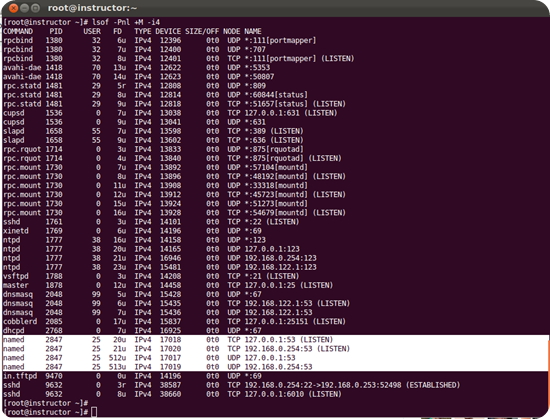

Los puertos que utilizan protocolos TCP y UDP ahora tienen soporte para el modulo so_reuseport que permiten múltiples conexiones y escuchas en el mismo puerto, esto es algo tremendamente útil en entornos de virtualización donde se crean numerosas direcciones IP virtuales.

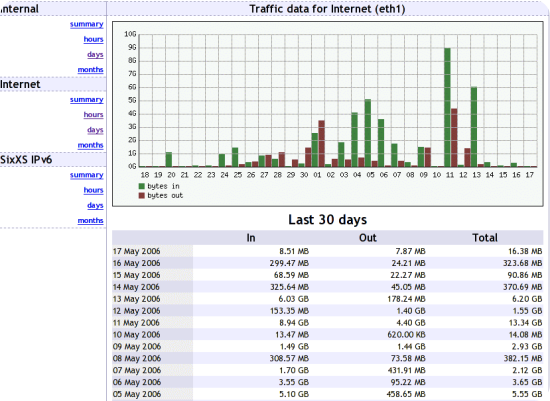

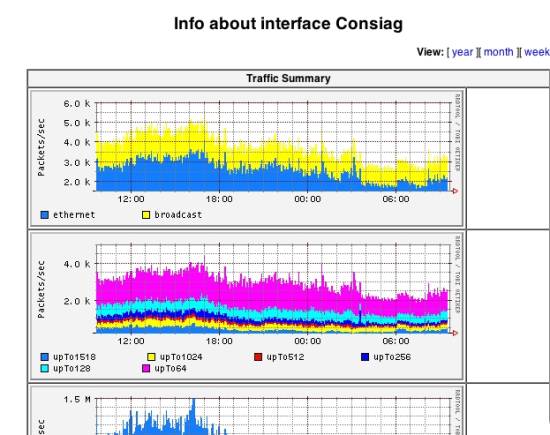

Se corrigen varios errores relacionados con la subida y bajada de datos simultáneamente en algunos entornos concretos.

Controladores.

Los cambios mas abundantes en la nueva rama 3.11 del Linux kernel son la incorporación de muchos controladores nuevos. Ahora ya esta soportada toda la linea de adaptadores Wi-Fi de Intel de forma nativa en el kernel por lo que aumentara el rendimiento de red si disponemos de una de estas tarjetas en nuestro portátil u ordenador de sobremesa. Ademas de las tarjetas Intel, también tenemos cambios en los controladores para tarjetas Atheros y Broadcom soportando nuevos modelos de chips y tarjetas recientes que han salido al mercado a finales de 2012 y principios de 2013.

También se soportan muchos dispositivos considerados exóticos o no estándares, como los ultraportatiles de Samsung Serie 3 con procesador ARM, muchos equipos Chromebook de Google y diversos smartphones y tablets.

Gráficos.

En el apartado de los gráficos tenemos cambios y novedades muy interesantes, sobretodo de cara a los que prefieren los controladores libres. Ahora esta soportada al completo la serie Radeon HD 7000 de AMD y HD 8000 de gama media como los modelos de la familia AMD Radeon HD 8500 y 8600. También están soportadas las tarjetas y procesador APU con chip equivalentes a las Radeon mencionadas de escritorio o portátil.

También se mejora el soporte para las tarjetas Nvidia GeForce desde la serie 6000 hasta la 9000 incluyendo sus equivalentes de la familia Quadro. Se mejora y completa el soporte para la serie 500 y se añade soporte experimental de la serie 69X y 700.

Arquitecturas de procesadores.

Ademas de la extensa lista de procesadores soportados en el Linux kernel, en esta nueva versión 3.9 se añade soporte para los procesadores ARC de Synopsys y algunas nuevas plataformas bajo la arquitectura ARM de 64-Bits.

Uno de los detalles donde mas se ha trabajado en el kernel 3.11 es en el código que comprime y descomprime el kernel en el formato LZO, mejorando notablemente el rendimiento en los equipos que tengan configurado el kernel para utilizar LZO en vez de Gzip. El rendimiento llega hasta duplicarse en algunos procesadores.

Virtualización.

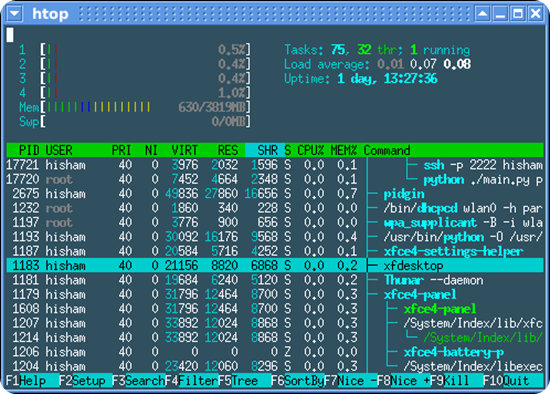

Se ha mejorado el hypervisor KVM que poco a poco ya esta llegando a un estado de madurez considerable, no hace mucho tiempo que solo se consideraba un modulo experimental, ahora ya dispone de toda una infraestructura propia. El cambio mas importante en KVM es el soporte para trabajar con las arquitecturas ARM, en especial con las características de virtualización que incorporan los procesadores de la plataforma Cortex-A15.

Ademas de mejorar KVM otra característica muy solicitada en los entornos profesionales es la de desconexión de procesadores en caliente. En la versión 3.10 del kernel se introducía esta característica como pudimos ver en Leanuxeros, pero ahora también se extiende el soporte para los entornos virtualizados con KVM.

Gestión de energía.

Como pudimos ver hace unos días, se esta trabajando muy fuerte en mejorar la gestión de energía de la memoria RAM y chips similares. Con la nueva versión 3.11 se incorporan parte de estos avances. Todos los nuevos equipos con memoria DDR3 ya tienen algunas funciones avanzadas para ahorrar energía, algunas de ellas ya las explicamos en el articulo sobre la gestión de energía de la memoria RAM.

Uno de los aspectos donde también se ha trabajado mucho es en la suspensión e hibernación del equipo. Ahora la suspensión utilizara menos energía en los equipos modernos donde los componentes pueden funcionar con casi la mitad de energía que con equipos antiguos. Antes se utilizaba el mismo estándar para todos, de esta manera ahora se sacara el máximo partido al hardware sea cual sea la generación. Con el nuevo kernel 3.11 podemos tener un equipo portátil en suspensión algunas horas mas que con versiones anteriores del kernel.

Si te ha gustado el artículo inscribete al feed clicando en la imagen más abajo para tenerte siempre actualizado sobre los nuevos contenidos del blog:

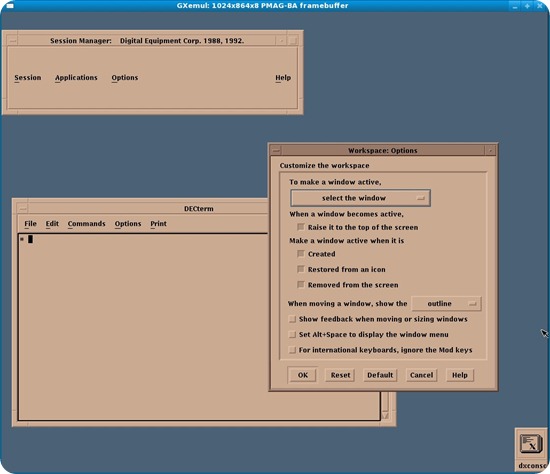

![linux disco duro_thumb[2] linux disco duro_thumb[2]](http://lh5.ggpht.com/-GghANy-9jvw/UizH4Z03MhI/AAAAAAAAMtI/4omvJn5T9d4/linux-disco-duro_thumb2_thumb.jpg?imgmax=800)

JW Player

JW Player

KDE

KDE